تعریف شبکههای عصبی مصنوعی و اهمیت آنها در هوش مصنوعی

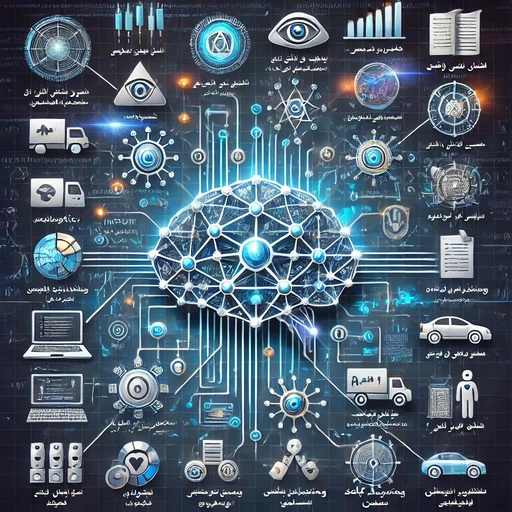

شبکه عصبی مصنوعی (Artificial Neural Network یا به اختصار ANN) به عنوان یکی از مفاهیم کلیدی و پایه در هوش مصنوعی شناخته میشود. این شبکهها مدلی محاسباتی هستند که با الهام از ساختار و عملکرد مغز انسان ساخته شدهاند و نقش حیاتی در رشد و پیشرفت مدلهای یادگیری ماشین و الگوریتمهای هوش مصنوعی دارند.

شبکه عصبی مصنوعی به زبان ساده، سیستمی متشکل از تعداد زیادی «نورون مصنوعی» یا «گره» است که به صورت لایهوار به هم متصل میشوند. هر نورون نقش پردازش یک بخش از اطلاعات را دارد و دادهها را به کمک وزنها و اتصالات میان لایهها، انتقال و تحلیل میکند. ایده اصلی طراحی شبکههای عصبی شبیهسازی نحوه یادگیری و حل مسئله در مغز انسان است.

پیدایش این ایده به دهه ۱۹۵۰ میلادی بازمیگردد، زمانی که دانشمندان با الهام از مدل زیستی مغز، اولین شبکه عصبی مصنوعی را معرفی کردند.

چرا شبکههای عصبی برای هوش مصنوعی مهم هستند؟

شبکههای عصبی مصنوعی، موتور محرک موفقیتهای عظیم هوش مصنوعی مدرن محسوب میشوند. آنها قابلیت تشخیص الگوهای پیچیده، یادگیری از دادههای خام، و بهینهسازی مدلها را دارند؛ ویژگیهایی که اکثر الگوریتمهای کلاسیک یادگیری ماشین فاقد آن هستند. این شبکهها اساس یادگیری عمیق، بینایی ماشین، ترجمه ماشینی، تحلیل تصویر و بسیاری از پیشرفتهای فوقالعاده در کاربردهای هوش مصنوعی را فراهم کردهاند.

- امکان یادگیری از دادههای زیاد و بدون نیاز به برنامهنویسی صریح قوانین

- توانایی تشخیص الگوهای پنهان و روابط غیرخطی در دادهها

- انعطافپذیری برای حل مسائل پیچیده مثل پردازش تصویر، صوت و زبان طبیعی

- پایه و اساس یادگیری عمیق (Deep Learning)، شاخه پیشرفته هوش مصنوعی

- امکان تحول کاربردهای روزمره: از دستیارهای صوتی تا خودروهای خودران و تشخیص پزشکی

| ویژگی | الگوریتمهای سنتی | شبکههای عصبی مصنوعی |

|---|---|---|

| توان تحلیل اطلاعات پیچیده | محدود | بسیار بالا |

| استفاده از دادههای بزرگ | کمتر موثر | قابل توسعه و قدرتمند |

نمونههایی از کاربرد شبکههای عصبی

تشخیص چهره در عکسها، ترجمه زبانها توسط چتباتهای هوشمند، سیستمهای توصیهگر، و حتی شناسایی بیماریها از جمله دستاوردهایی است که به لطف شبکههای عصبی مصنوعی در هوش مصنوعی میسر شده است.

در ادامه، به جزئیات بیشتری درباره ساختار لایهها، نقش نورون مصنوعی، فرایند آموزش شبکهها و سایر جنبههای فنی شبکههای عصبی خواهیم پرداخت. اگر به دنیای مدلهای یادگیری ماشین و یادگیری عمیق علاقهمندید، پیشنهاد میکنیم بخشهای بعدی را از دست ندهید.

ساختار لایهها در شبکههای عصبی و عملکرد هر لایه

شبکههای عصبی مصنوعی نقش محوری در حوزه هوش مصنوعی دارند و ساختار آنها مبتنی بر ترکیب چندین "لایه" است. هر لایه گام مهمی در مسیر پردازش و تفسیر دادهها انجام میدهد، درست مانند مراحلی که ذهن انسان برای حل یک مسئله طی میکند. بیایید با یک مثال ساده مربیگری فوتبال شروع کنیم؛ تصور کنید بازیکنان دادهها (ورودیها) هستند، مربیان میانجی و تحلیلگرها (لایههای مخفی) فرآیند تصمیمگیری و انتخاب استراتژی را انجام میدهند، و در نهایت، نتیجه بازی (لایه خروجی) مشخص میشود.

(input, hidden, output)لایه در شبکه عصبی یک مجموعه از نورونهای مصنوعی است که بهطور موازی، بخش خاصی از وظیفه پردازش داده را بر عهده دارند. معماری شبکه عصبی معمولا شامل سه نوع لایه اصلی است: لایه ورودی، لایههای مخفی و لایه خروجی. شناخت هر لایه و کارکرد آن پایه درک عملکرد شبکههای عصبی مدرن مثل سیستمهای پیشرفته هوش مصنوعی را شکل میدهد.

۱. لایه ورودی (Input Layer)

- وظیفه: دریافت داده خام و انتقال آن به شبکه عصبی

- مثال: هر نورون نماینده یک ویژگی داده ورودی (مثلاً یک پیکسل از عکس یا یک مقدار از جدول دادهها) است.

- جایگاه: اولین لایه در معماری شبکه عصبی

۲. لایههای مخفی (Hidden Layers)

- وظیفه: استخراج و یادگیری ویژگیهای پیچیده و غیرخطی از دادهها

- نکته کلیدی: هرچه تعداد لایههای مخفی بیشتر، شبکه قادر به یادگیری ارتباطات و الگوهای عمیقتر خواهد بود (در مدلهای یادگیری عمیق این لایهها اهمیت ویژه دارند).

- جایگاه: بین لایه ورودی و خروجی قرار دارند؛ ممکن است یک یا چند لایه باشند.

- عملکرد: در هر لایه مخفی، دادهها تحت تبدیل ریاضی و توابع فعالساز (مثل ReLU، Sigmoid) قرار میگیرند.

۳. لایه خروجی (Output Layer)

- وظیفه: ارائه نتیجه نهایی مانند دستهبندی، پیشبینی عددی یا تصمیم

- مثال: در یک مسأله تشخیص تصویر، این لایه مشخص میکند عکس متعلق به کدام دسته است.

- جایگاه: آخرین لایه و خروجی نهایی شبکه

- تعداد نورون: با نوع مسئله مرتبط است؛ مثلاً برای طبقهبندی n کلاس، به n نورون نیاز خواهیم داشت.

مقایسه سه نوع لایه شبکه عصبی مصنوعی

| نوع لایه | جایگاه در شبکه | عملکرد اصلی | تعداد نورون (نمونه) |

|---|---|---|---|

| لایه ورودی | آغاز شبکه | ورود دادههای خام | برابر ویژگیهای داده (مثلاً 784 برای تصویر 28×28) |

| لایه مخفی | میان شبکه | یادگیری الگوها و ویژگیها | قابل تنظیم؛ معمولاً بین 16 تا هزاران نورون |

| لایه خروجی | پایان شبکه | ارائه پاسخ یا نتیجه | بر اساس نوع جواب؛ مثلا 1 یا تعداد کلاسها |

جریان دادهها در شبکه عصبی

دادهها در شبکه عصبی، نخست وارد لایه ورودی میشوند. سپس این اطلاعات به منظور پردازش و استخراج ویژگی به لایههای مخفی منتقل خواهند شد و پس از عبور از چندین مرحله پردازش، به لایه خروجی میرسند تا تصمیم نهایی یا پیشبینی اعلام گردد. نکته مهم این است که معماری شبکه و تعداد لایهها بسته به نوع مساله هوش مصنوعی و عمق تحلیل مورد نیاز قابل تغییر است.

سوالات متداول درباره ساختار لایهها

چه تعداد لایه مخفی لازم است؟

تعداد لایههای مخفی بسته به پیچیدگی مساله و نوع داده متغیر است. برای مسایل ساده ممکن است یک لایه کافی باشد، اما در شبکههای عمیقتر دهها یا صدها لایه استفاده میشود.

آیا شبکه عصبی همیشه به هر سه نوع لایه نیاز دارد؟

معمولا بله. حتی سادهترین شبکهها به یک لایه ورودی و یک لایه خروجی نیاز دارند و برای حل مسائل پیچیدهتر از یک یا چند لایه مخفی استفاده میکنند.

خروجی هر لایه چگونه منتقل میشود؟

خروجی هر لایه مستقیماً به لایه بعدی ارسال میشود تا در کل، داده از آغاز تا پایان شبکه عصبی جریان پیدا کند.

برای آشنایی بیشتر با مفاهیم کلیدی شبکه عصبی و کاربرد آن در هوش مصنوعی، مطالعه بررسی مفاهیم یادگیری ماشین و هوش مصنوعی ۱۰۱ را از دست ندهید.

نقش نورون مصنوعی در پردازش دادهها

نورون مصنوعی، قلب تپنده فناوری هوش مصنوعی و شبکههای عصبی است. این بخش کوچک اما حیاتی، همانند واحد بنیادی پردازشگر مغز انسان عمل میکند و مسئول تحلیل و تبدیل اطلاعات ورودی به خروجیهای معنادار است. اما این نورون مصنوعی دقیقاً چگونه دادهها را پردازش میکند؟ بیایید به زبان ساده، قدم به قدم این روند را بررسی کنیم.

نورون مصنوعی چیست؟

نورون مصنوعی یا Perceptron، یک مدل ریاضی است که از نورون واقعی الهام گرفته شده است و عملکرد اصلی آن، جمعآوری ورودیها، وزندهی، اعمال بایاس و در نهایت خروجی گرفتن پس از عبور از یک تابع فعالساز است. برخلاف مغز، این فرایند کاملاً دیجیتال و مبتنی بر محاسبه است، ولی نقشی بنیادین در رشد و پیشرفت هوش مصنوعی ایفا میکند.

روند گامبهگام پردازش داده در نورون مصنوعی

هر نورون مصنوعی طبق مراحل زیر دادهها را پردازش میکند:

- 1. ورودیها (Inputs): دادههایی که از بیرون وارد نورون میشوند (مانند پیکسلهای یک تصویر، یا اعداد یک جدول).

- 2. وزنها (Weights): هر ورودی به یک ضریب (وزن) ضرب میشود که اهمیت آن را تعیین میکند.

- 3. بایاس (Bias): یک عدد ثابت که به جمع ورودیها اضافه میشود تا وزندهی انعطافپذیرتر شود.

- 4. تابع فعالساز (Activation Function): روی نتیجه اعمال میشود تا تصمیمگیری نهایی نورون انجام شود (مثلاً خروجی صفر یا یک).

- 5. خروجی (Output): نتیجه نهایی که به لایه بعدی یا خروجی شبکه منتقل میشود.

جدول: اجزای نورون مصنوعی و کاربرد هر بخش

مثال کاربردی: تصمیمگیری نورون در دستهبندی تصویر

فرض کنید یک نورون مصنوعی قرار است تشخیص دهد که یک تصویر شامل گربه است یا نه. هر پیکسل تصویر یک ورودی خواهد بود، وزنها قدرت تاثیر آن پیکسل را مشخص میکنند، بایاس حالت کلی را کنترل میکند و تابع فعالساز مثلاً اگر مقدار خروجی از ۰.۵ بیشتر شد، میگوید «بله، این تصویر گربه دارد». این فرایند حتی در شبکههای عصبی پیشرفتهتر که در ساختار لایهها در شبکههای عصبی بررسی شده نیز پایه ماجرا ست.

کد ساده Python برای یک نورون مصنوعی

فرض کنید x1 و x2 دو ورودی هستند

w1 و w2 وزنها، b بایاس، و تابع فعالساز سیگموید

import math def sigmoid(x): return 1 / (1 + math.exp(-x)) x1, x2 = 0.7, 0.2 # ورودیها w1, w2 = 0.4, -0.6 # وزنها b = 0.1 # بایاس output = sigmoid(x1*w1 + x2*w2 + b) print(output) # خروجی نورون مصنوعی

نکته مهم

تمام یادگیری و تصمیمگیری شبکه عصبی پیچیده، با همین اصول ساده نورون مصنوعی در هسته کار آغاز میشود.

نتیجهگیری: نورون مصنوعی، واحد پایه پردازش اطلاعات در هوش مصنوعی است و بدون آن پیشرفتی در هوش مصنوعی و ساخت شبکههای عصبی امکانپذیر نیست. هر چه این واحدها بهتر و دقیقتر کار کنند، سطح هوشمندی ماشین بالاتر میرود.

فرآیند آموزش شبکه عصبی: از دادهها تا یادگیری

آموزش شبکههای عصبی مصنوعی مهمترین مرحله برای تبدیل این مدلها به ابزارهای هوشمند در هوش مصنوعی است. فرآیند آموزش شبکه عصبی یعنی چطور دادههای خام مرحله به مرحله به مدل یادگیرنده تبدیل میشود که میتواند مسائل مختلف را حل کند. در این مسیر، مدل با استفاده از دادههای آموزشی، الگوها و قوانین را کشف میکند، خطاها را اصلاح مینماید و به تدریج به یک «سیستم هوشمند» تبدیل میشود. [بیشتر درباره نحوه کار هوش مصنوعی]

مراحل آموزش شبکه عصبی

- آمادهسازی دادههای آموزشی: دادهها باید دستهبندی و تمیز باشند تا مدل بتواند الگوها را بیاموزد.

- پیشروی جلو (Forward Pass): دادهها وارد شبکه میشوند و از لایهها عبور میکنند تا خروجی اولیه تولید شود.

- محاسبه تابع خطا (“Loss Function”): اختلاف خروجی شبکه با مقدار واقعی سنجیده میشود.

- پسانتشار و بروزرسانی وزنها: آموزش شبکه شامل تصحیح وزنها برای کاهش خطا (توضیح کامل در بخش الگوریتم پسانتشار خطا خواهد آمد).

- تکرار فرآیند (Epoch): این چرخه بارها برای تمام دادههای آموزشی تکرار میشود تا مدل به نتیجه مطلوب برسد.

- ارزیابی مدل: پس از پایان آموزش، کارایی مدل با دادههای جدید سنجیده میشود.

چرا دادههای آموزشی تمیز و مناسب کلیدی هستند؟

اگر دادهها ناقص یا نادرست باشند، شبکه عصبی نمیتواند الگوهای درست را بیاموزد و خطاهای خروجی افزایش پیدا میکند. آمادهسازی مناسب داده اولین گام حیاتی برای موفقیت آموزش هر مدل هوش مصنوعی است.

برای آشنایی بیشتر با مفاهیم داده و آموزش مدلها مقاله بررسی مفاهیم یادگیری ماشین را مطالعه کنید.

اهمیت تکرار در آموزش: epoch، batch و iteration

آموزش کامل شبکههای عصبی اغلب دهها یا صدها بار بر روی کل دادهها تکرار میشود. به این چرخهها در آموزش epoch میگویند. اما چون دادهها بزرگ هستند، معمولاً به بخشهای کوچکتر (batch) تقسیم میشوند و هر بار که روی یک مجموعهٔ کوچک عملیات انجام میشود به آن iteration گفته میشود.

| اصطلاح | تعریف | مثال ساده |

|---|---|---|

| Epoch | یک بار عبور کامل از کل دادههای آموزشی | مطالعه تمام صفحات یک کتاب |

| Batch | زیرمجموعهای کوچک از دادهها که پردازش میشود | خواندن ۱۰ صفحه از کتاب در هر نوبت |

| Iteration | یک بار پردازش یک batch | هر بار خواندن همان ۱۰ صفحه |

فرآیند تکرار و تصحیح خطا

هر بار که شبکه عصبی خروجی تولید میکند، مقدار خروجی با عدد درست مقایسه میشود و خطا محاسبه میگردد. این خطا همان معلم شبکه است: با تکرار و تصحیح خطا، مدل به تدریج به بهترین حالت خود نزدیک میشود. جزئیات کامل الگوریتمهای بهینهسازی و تصحیح خطا در بخش الگوریتم پسانتشار خطا و بهبود عملکرد شبکه بررسی خواهد شد.

نکته:

استفاده از منابع قوی و تحریمشکنها گاهی برای آموزش یا بهروزرسانی مدلهای شبکه عصبی ضروری است، خصوصاً هنگام دریافت داده یا استفاده از ابزارهای آنلاین هوش مصنوعی.

راهنمای کامل استفاده رایگان از هوش مصنوعی

حالا که با چرخه آموزش شبکه عصبی مصنوعی آشنا شدید، قدم بعدی برای درک بهتر، آشنایی با مفاهیم وزن و بایاس و تاثیر آنها در دقت یادگیری مدل است.

مفاهیم وزن و بایاس در شبکههای عصبی

وزن و بایاس، دو مفهوم اساسی و جداییناپذیر در حوزه شبکههای عصبی و هوش مصنوعی هستند که نقش تعیینکنندهای در یادگیری و دقت مدلهای هوشمند ایفا میکنند. بدون وزن (وزنها) و بایاس، هیچ دادهای نمیتواند بهدرستی پردازش و تفسیر شود و الگوریتمهای هوش مصنوعی عملاً بیفایده میشوند. در ادامه، به صورت تخصصی اما ساده اهمیت و کاربرد هر یک را بررسی میکنیم.

وزن چیست؟ (Weight in Neural Networks)

وزن (Weight) در شبکههای عصبی همان ضریبی است که به ورودیهای نورونها اختصاص داده میشود. هر ورودی به یک نورون ضربدر یک وزن شده و حاصل جمع ورودیهای وزندار پایه محاسبات بعدی هوش مصنوعی میشود.

به زبان ساده، وزن مقدار تأثیر هر ورودی بر خروجی را مشخص میکند؛ هرچه مقدار وزن بیشتر باشد، تأثیر آن ورودی نیز روی نتیجه بیشتر خواهد بود.

- هر ارتباط بین نورونها یک وزن دارد.

- افزایش یا کاهش وزنها مستقیماً بر عملکرد یادگیری شبکههای عصبی تاثیر میگذارد.

- تنظیم وزنها مهمترین فرآیند در یادگیری هوش مصنوعی، خصوصاً یادگیری عمیق است.

ویژگیهای وزن در شبکه عصبی

- تعریفکننده میزان اهمیت هر ورودی

- آغاز به صورت تصادفی و قابل تنظیم در حین آموزش

- تغییر وزن = تغییر عملکرد و دقت مدل هوش مصنوعی

بایاس چیست؟ (Bias in Neural Networks)

بایاس (Bias) عدد ثابتی است که به مجموع ورودیهای وزندار یک نورون اضافه میشود. نقش بایاس در شبکههای عصبی مشابه «تنظیم پایه» (offset) برای خروجی نورون است؛ یعنی اگر همه ورودیها صفر باشند، بایاس همچنان میتواند فعالشدن یا نشدن یک نورون را کنترل کند.

مثال ساده: اگر وزنها مانند دسته سر و صدای هر ورودی باشند، بایاس شبیه مقدار پیشفرض ولوم است که حتی بدون هیچ ورودی، صدایی به گوش برسد.

- بایاس، منعطفکننده قدرت تصمیمگیری نورونهاست.

- استفاده از بایاس امکان یادگیری روابط غیرخطی را در هوش مصنوعی فراهم میکند.

- بایاس معمولاً برای هر نورون بهصورت مستقل تعریف میشود.

مزایای تنظیم بایاس

- ایجاد انعطاف برای یادگیری تابعهای پیچیدهتر

- کاهش خطای مدل در برخی شرایط خاص

- امکان فعالسازی نورون حتی در صورت عدم وجود ورودی فعال

فرق وزن و بایاس در شبکههای عصبی

| وزن (Weight) | بایاس (Bias) |

|---|---|

| ضریب برای هر ورودی (بین نورونها) | یک مقدار ثابت جدا برای نورون |

| مستقیماً تعیینکننده تاثیر هر ورودی | تعیینکننده آستانه فعالشدن نورون |

| قابل تغییر و تنظیم حین یادگیری | معمولاً یک مقدار قابل یادگیری مستقل |

چگونه وزن و بایاس در آموزش شبکه عصبی تأثیر دارند؟

تنظیم مناسب وزن و بایاس برای دستیابی به دقت بالا در مدلهای هوش مصنوعی الزامی است. هر اشتباه در مقدار اولیه یا بهروزرسانی وزن و بایاس منجر به خروجی نامطلوب یا حتی عدم یادگیری میشود.

معمولاً در فرآیند آموزش (در زیرعنوانهای و توضیح داده میشود) این پارامترها توسط الگوریتمهایی مانند پسانتشار خطا (backpropagation) بهینه میشوند.

سوالات متداول (FAQ) درباره وزن و بایاس

- چرا وزنها باید تنظیم شوند؟

برای این که مدل هوش مصنوعی با دادهها سازگار شود و بتواند خروجی دقیق ارائه دهد. - آیا بایاس همیشه لازم است؟

در اکثر شبکههای عصبی برای افزایش انعطاف و دقت مدل توصیه میشود که از بایاس استفاده شود. - تفاوت اصلی وزن و بایاس چیست؟

وزن تاثیر ورودی را مشخص میکند؛ بایاس یک مقدار پایه است که آستانه فعالسازی را جابهجا میکند.

خلاصه

وزن و بایاس از عناصر کلیدی شبکههای عصبی در حوزه هوش مصنوعی هستند و نقش اساسی در موفقیت یادگیری و تحلیل دادهها دارند. بدون وزن و بایاس، هیچ شبکه عصبی نمیتواند هوشمندانه عمل کند.

آیا تجربهای در تنظیم وزن و بایاس دارید؟

تجربههای خود درباره تنظیم وزن و بایاس در پروژههای هوش مصنوعی را در کامنتها با ما و دیگر علاقهمندان به اشتراک بگذارید!

الگوریتم پسانتشار خطا و بهبود عملکرد شبکه

یکی از محرکهای اصلی پیشرفت هوش مصنوعی و یادگیری ماشین، الگوریتم قدرتمند پسانتشار خطا (Backpropagation) است. این الگوریتم به عنوان قلب فرایند آموزش شبکههای عصبی شناخته میشود و مسئول کاهش خطای پیشبینی با بهبود وزنها و بایاسها در شبکه است. بدون پسانتشار خطا، یادگیری صحیح شبکههای عصبی و توسعه مدلهای پیشرفته هوش مصنوعی تقریباً غیرممکن بود.

الگوریتم پسانتشار خطا چیست؟

الگوریتم پسانتشار خطا یا Backpropagation فرایندی برای محاسبه میزان خطا در خروجی شبکه و سپس انتقال این خطا به عقب درون شبکه است تا وزنها و بایاسها بهینهسازی شوند. به بیان ساده، این روش کمک میکند شبکه عصبی از اشتباهات خود بیاموزد و پارامترهایش را طوری اصلاح کند که خروجیهای آینده به جواب صحیح نزدیکتر شوند. پسانتشار خطا در واقع پایه اصلی بیشتر شبکههای عصبی مدرن و کلید آموزش خودکار مدلهای هوش مصنوعی است.

مراحل کار الگوریتم Backpropagation

اجرای این الگوریتم شامل دو فاز اصلی است: عبور رو به جلو (Forward Pass) و عبور به عقب (Backward Pass). مراحل کلیدی را میتوان به شکل زیر خلاصه کرد:

- عبور رو به جلو: دادههای ورودی به شبکه داده میشوند و خروجی شبکه محاسبه میشود.

- محاسبه خطا: تفاوت خروجی واقعی (پیشبینی شبکه) و خروجی مطلوب (داده آموزش) با یک تابع هزینه (مانند MSE) محاسبه میشود.

- عبور به عقب: خطا از لایه خروجی به سمت لایههای قبلی بازگردانده میشود تا تأثیر هر وزن و بایاس روی خطا مشخص شود.

- بهروزرسانی وزنها و بایاسها: با استفاده از تکنیک نشیبشیب (Gradient Descent)، وزنها و بایاسها به گونهای تنظیم میگردند که خطای شبکه کاهش یابد.

نحوه بهبود عملکرد شبکه با پسانتشار خطا

الگوریتم پسانتشار خطا این امکان را فراهم میکند که فراگیری شبکه عصبی به صورت پویا و داینامیک انجام شود و شبکه بتواند به سرعت، خطا را کاهش دهد. با هر تکرار (Epoch)، وزنها و بایاسها به اندازهای اصلاح میشوند که خروجیها به مقدار صحیح نزدیکتر شوند، در نتیجه:

- سرعت رسیدن به حداقل خطا (Convergence) به طور چشمگیری افزایش مییابد.

- شبکه قادر به شناسایی الگوهای پنهانتر و انجام استنتاجهای دقیقتر خواهد شد.

- دقت مدل هوش مصنوعی نسبت به روشهای بدون پسانتشار خطا، بسیار بالاتر میرود.

| ویژگی | بدون پسانتشار خطا | با پسانتشار خطا |

|---|---|---|

| سرعت یادگیری | کند و محدوده | سریع و موثر |

| دقت پیشبینی | پایین | بسیار بالا |

| قابلیت حل مسائل پیچیده | تقریباً غیرممکن | امکانپذیر و پیشرفته |

نکات طلایی برای مطلوبتر شدن پسانتشار خطا

- استفاده از الگوریتمهای بهینهسازی پیشرفته مانند Adam یا RMSprop برای تسریع و پایداری روند آموزش

- تنظیم دقیق نرخ یادگیری (Learning Rate) برای جلوگیری از پرش یا گیر کردن در مینیممهای محلی

- افزودن تکنیکهایی مانند Regularization جهت پیشگیری از بیشبرازش (Overfitting)

- بدست آوردن بهترین عملکرد با تنظیم دقیق اَبَرپارامترها (مطالعه بیشتر درباره یادگیری ماشین)

جمعبندی: نقش محوری پسانتشار خطا در هوش مصنوعی مدرن

در دنیای هوش مصنوعی پیشرفته، الگوریتم پسانتشار خطا ستون فقرات یادگیری شبکههای عصبی و مدلهای یادگیری عمیق است. این الگوریتم با امکان بهبود مستمر پارامترها، موجب افزایش دقت، سرعت و توانایی شبکهها در حل مسائل پیچیده میشود و سنگبنای بیشتر دستاوردهای قدرتمند هوش مصنوعی امروزی محسوب میگردد.

کاربردهای اصلی شبکههای عصبی در زندگی روزمره

شبکههای عصبی به عنوان یکی از موتورهای قدرتمند هوش مصنوعی، به طور مستقیم و غیرمستقیم نقش پررنگی در بهبود کیفیت زندگی روزمره ما دارند. امروزه اکثر سرویسها و تکنولوژیهایی که استفاده میکنیم، به نوعی از قدرت یادگیری و تشخیص پنهان همین شبکههای عصبی مصنوعی بهره میبرند. در این بخش، با مثالهای واقعی و ملموس، نقش کاربردی شبکههای عصبی را در زندگی روزانه بررسی میکنیم و میبینیم چطور این فناوری، سادهتر و هوشمندتر شدن جهان امروز را رقم زده است.

- دستیارهای صوتی و اسپیکرهای هوشمند (مانند Google Assistant، سیری یا الکسا): ظرفیت درک و پردازش صدای فارسی، پاسخ به پرسشها و حتی تشخیص گفتار محاورهای با کمک شبکههای عصبی پیشرفته، باعث شده استفاده از این ابزارها در خانههای ایرانی به سرعت محبوب شود.

- سیستمهای توصیهگر شخصیسازیشده (فیلم، موسیقی و فروشگاه آنلاین): اگر تجربه خرید از دیجیکالا یا گوش دادن به پلیلیست اسپاتیفای را داشته باشید، متوجه پیشنهادهای هوشمندانه میشوید. این پیشنهادها بر اساس علایق و رفتار کاربر، با الگوریتمهای شبکه عصبی پردازش و ارائه میشوند.

- تشخیص چهره (در گوشیهای هوشمند و سیستمهای امنیتی): گوشی خود را با چهره باز میکنید یا آلبوم عکس را با یک اشاره جستجو میکنید؟ این جادوی شبکههای عصبی در هوش مصنوعی است.

- خودروهای خودران و سامانههای کمک راننده: امروزه خودروهای هوشمند (حتی برخی مدلهای مونتاژ داخل!) در مسیر تشخیص اشیا، تابلوهای راهنمایی و حتی رانندگی نیمهخودکار از شبکههای عصبی بهره میبرند.

- فیلتر هرزنامه و تشخیص پیامک تبلیغاتی یا اسپم: بسیاری از سرویسهای ایمیل (مثل جیمیل) و اپراتورهای تلفن همراه، برای تشخیص و فیلتر پیامهای ناخواسته، از یادگیری عمیق توسط شبکههای عصبی استفاده میکنند تا صندوق ورودی شما را پاکیزه نگه دارند.

- پشتیبانی سلامت و پزشکی هوشمند: تشخیص اوایل علائم بیماری (مثل کووید، سرطان، مشکلات پوستی و…) با کمک هوش مصنوعی شبکههای عصبی در آزمایشگاهها و اپلیکیشنهای پزشکی، حتی در ایران، به واقعیت پیوسته است. مطالعه بیشتر درباره نقش هوش مصنوعی در پزشکی

- خانههای هوشمند و اینترنت اشیا: ترموستاتها، دوربینهای امنیتی، و حتی جاروبرقیهای رباتیک، با تحلیل الگوی رفتاری کاربران توسط شبکه عصبی، محیط خانه را هوشمندتر و امنتر کردهاند.

- مدیریت محتوا و شبکههای اجتماعی: فیلتر خودکار محتوای غیراخلاقی یا خشونتآمیز، رتبهبندی پستها و تگگذاری تصاویر در پلتفرمهایی مانند اینستاگرام و تلگرام توسط شبکههای عصبی انجام میشود. همین فناوریها برای کاربران ایرانی هم به خصوص در بحث ترجمه و اعتدال محتوا کاربرد عملی فراوان دارند.

- ترجمه هوشمند و تشخیص متن (مانند Google Translate، مترجمهای آنلاین فارسی): ترجمه دقیق متون فارسی به انگلیسی و بالعکس یا حتی پیشبینی کلمه بعدی هنگام نوشتن پیام، همه با قدرت شبکههای عصبی هوش مصنوعی انجام میشود.

- امنیت بانکی و تشخیص تقلب در تراکنش: بانکهای ایرانی و شرکتیهای فینتک با تحلیل رفتار تراکنشها و شناسایی موارد مشکوک، امنیت مالی کاربران را با استفاده از شبکههای عصبی ارتقا دادهاند.

نمونههای کاربرد شبکه عصبی در ایران

• سرویسهای پرداخت و کیف پول ایرانی با الگوریتمهای یادگیری عمیق از کلاهبرداری جلوگیری میکنند.

• اپهای فارسی پیشبینی متن و تشخیص صدا (مانند سامانههای هوشمند تسکین یا پیامرسانها) از شبکه عصبی برای فهم بهتر زبان فارسی استفاده مینمایند.

• سیستمهای توصیهگر ایرانی (مثلاً برای ویدیو یا خرید آنلاین) رفتار کاربر را تحلیل و پیشنهادهای شخصیسازیشده ارائه میدهند.

شگفتآور است بدانید بسیاری از این سرویسها روزانه در حال بهروزرسانی و هوشمندتر شدن هستند و تنها بخش کوچکی از تاثیر شبکههای عصبی مصنوعی بر زندگی روزمره را نشان میدهند. اگر علاقهمند به آشنایی فنیتر با چگونگی عملکرد این شبکهها هستید، سراغ بخشهای ساختار لایهها و فرآیند آموزش شبکه عصبی در این مقاله بروید.

تفاوت شبکههای عصبی مصنوعی با مغز انسان

شبکههای عصبی مصنوعی (ANN) یکی از پرطرفدارترین رویکردها در هوش مصنوعی هستند و از ساختار مغز انسان الهام گرفته شدهاند. اما آیا واقعاً میتوان این دو را یکسان دانست؟ در ادامه، نقطهبهنقطه تفاوت اصلی میان شبکه عصبی مصنوعی و مغز انسان را بررسی میکنیم تا شفافیت بیشتری درباره تواناییها، محدودیتها و چالشهای این دو داشته باشید.

مقایسه ساختاری و عملکردی: مغز انسان در برابر شبکه عصبی مصنوعی

| ویژگی کلیدی | شبکه عصبی مصنوعی | مغز انسان |

|---|---|---|

| واحد پایه | نورون مصنوعی (محاسبه عددی ساده، فاقد ساختار زیستی) | نورون بیولوژیکی (شیمیایی و الکتریکی، فوقالعاده پیچیده) |

| مقیاس و پیچیدگی | تا میلیاردها پارامتر در پیشرفتهترین مدلها | حدود ۸۶ میلیارد نورون با ۱۰۰ تریلیون ارتباط سیناپسی |

| نوع یادگیری | بهینهسازی ریاضی (گرادیان/پسانتشار خطا)، اکثراً آموزش متمرکز بر داده ثابت | یادگیری پیوسته، انعطافپذیر، مبتنی بر تجربه و تطابق با محیط (Plasticity) |

| تطبیق با شرایط جدید | معمولاً محدود؛ خارج از دادههای آموزشدادهشده ضعیف عمل میکند | قدرت تعمیم، خلاقیت و تصمیمگیری در شرایط ناشناخته |

| موازیسازی و بهرهوری انرژی | موازیسازی ساختاری؛ اما مصرف انرژی بسیار بالا (هزاران وات برای یک مدل بزرگ) | موازیسازی غیرساختاری و انعطافپذیر؛ مصرف انرژی بسیار پایین (<20 وات برای کل مغز) |

چند نمونه از تفاوتهای مهم دیگر:

- شبکههای عصبی مصنوعی مسیر یادگیری را فقط از دادههای زیاد و تمرینهای تکراری دریافت میکنند، در صورتی که مغز انسان از تعامل روزمره و حتی خواب یاد میگیرد.

- در ANN خروجی هر نورون معمولاً ریاضی و قابل پیشبینی است؛ اما نورونهای انسان با مواد شیمیایی، حافظه کوتاه و بلندمدت و حتی احساسات تعامل دارند.

- مغز بدون نیاز به برنامهریزی مجدد میتواند انواع اطلاعات را ترکیب و تحلیل کند، اما هر نوع شبکه عصبی مصنوعی برای وظیفه خاصی طراحی میشود و قابل استفاده عمومی نیست.

پرسشهای رایج درباره شباهت و تفاوت شبکه عصبی با مغز انسان

- آیا شبکههای عصبی واقعا مغز انسان را شبیهسازی میکنند؟

خیر؛ آنها فقط از ساختار مغز الهام گرفتهاند اما سادگی بسیار بیشتری دارند و رفتارهای بیولوژیک، احساسات یا خلاقیت را بازآفرینی نمیکنند. - آیا ممکن است شبکههای عصبی روزی از مغز پیشی بگیرند؟

فعلاً تمامی سیستمهای پیشرفته فقط در کارهای خاص و با حجم دادههای زیاد بهتر از انسان عمل میکنند، اما گستره توانایی، تطبیق و بهرهوری مغز انسان دستنیافتنی باقی مانده است. - چطور میتوان درباره نورونهای مصنوعی بیشتر یاد گرفت؟

پیشنهاد میکنیم بخش نقش نورون مصنوعی در پردازش دادهها را مطالعه کنید.

جمعبندی: در حالی که شبکههای عصبی مصنوعی راهی نوین برای پیشبرد هوش مصنوعی محسوب میشوند، اما به لحاظ ساختار، تطبیق و پیچیدگی، هنوز فاصله بزرگی با مغز انسان دارند و نمیتوان آنها را نسخه دیجیتال یا جایگزینی برای مغز انسانی دانست.

انواع شبکههای عصبی و مقایسه آنها

یکی از مهمترین پیشرفتها در هوش مصنوعی، ظهور انواع مختلف شبکههای عصبی مصنوعی است که هر کدام بر اساس ساختار و کاربردشان، نقش خاصی در حل مسائل پیچیده ایفا میکنند. انتخاب نوع صحیح شبکه عصبی، تأثیر مستقیمی بر دقت، سرعت و موفقیت پروژههای هوش مصنوعی دارد. اما انواع مختلف شبکه عصبی چیست و هریک چه مزایا و موارد استفادهای دارند؟ در این بخش مهمترین مدلها را معرفی و آنها را با هم مقایسه میکنیم.

۱. پرسپترون (Perceptron) – سادهترین مدل شبکه عصبی

- ساختار: تنها یک لایه نورون (تک لایهای)، بدون لایه پنهان

- کاربرد: جداسازی خطی دادهها (مسائل ساده طبقهبندی)

- مزایا: فهم ساده، اجرای سریع

- معایب: ناتوان در حل مسائل پیچیده یا غیرخطی

۲. شبکههای عصبی پیشخور (Feedforward Neural Network – FFNN)

- ساختار: چندین لایه نورون (ورودی، مخفی، خروجی)، بدون حلقه بازخور

- کاربرد: طبقهبندی داده، پیشبینی عددی، تشخیص الگو

- مزایا: قابل توسعه، مناسب برای انواع مسائل پایه هوش مصنوعی

- معایب: عدم توانایی در پردازش اطلاعات زمانی (Sequence)

۳. شبکههای عصبی کانولوشنی (Convolutional Neural Network – CNN)

- ساختار: دارای لایههای کانولوشنی مخصوص استخراج ویژگی از دادههای تصویری یا فضایی

- کاربرد: شناسایی تصویر، تشخیص چهره، بینایی ماشین، تحلیل ویدیو

- مزایا: استخراج خودکار ویژگی، عملکرد بینظیر در مسائل تصویری

- معایب: نیازمند داده و توان پردازشی بالا

۴. شبکههای عصبی بازگشتی (Recurrent Neural Network – RNN)

- ساختار: شامل حلقههای بازخور برای ذخیره اطلاعات گذشته

- کاربرد: زبان طبیعی، ترجمه ماشینی، پردازش صوت و سریهای زمانی

- مزایا: مناسب برای دادههای متوالی و وابسته به زمان

- معایب: مسئله فراموشی طولانی مدت (Vanishing Gradient)

۵. LSTM و GRU – شبکههای بازگشتی پیشرفته

- ساختار: زیرنوع RNN با مکانیزم ذخیره و فراموشی بهتر (دروازههای حافظه)

- کاربرد: ترجمه خودکار، آنالیز سری زمانی پیچیده، مولد شعر و متن

- مزایا: حفظ وابستگیهای طولانی، رفع مشکل فراموشی RNN

- معایب: پیادهسازی پیچیدهتر، مصرف حافظه بالاتر

۶. شبکههای مولد خصمانه (Generative Adversarial Networks – GANs)

- ساختار: دو شبکه (مولد + متمایزکننده) در مقابل هم کار میکنند

- کاربرد: تولید تصویر و ویدیو جدید، خلق آثار هنری، ساخت داده مصنوعی

- مزایا: تولید داده با کیفیت بالا، نوآوری در کیفیت هوش مصنوعی مولد

- معایب: تنظیم سخت و احتمالا ناپایداری در آموزش

۷. شبکههای شعاع تابع پایه (RBF Network)

- ساختار: بر پایه توابع شعاعی برای طبقهبندی سریع دادهها

- کاربرد: تشخیص الگو، طبقهبندی غیرخطی با حجم کم داده

- مزایا: آموزش سریع و ساده برای برخی مسائل

- معایب: مقیاسپذیری ضعیف برای دادههای بزرگ

جدول مقایسه: انواع شبکههای عصبی مصنوعی در هوش مصنوعی

مثالهای کاربردی در زندگی:

برای شناسایی تصویر، شبکههای CNN بهترین انتخاب هستند. برای ترجمه متن یا تبدیل گفتار به نوشتار، معمولا RNN یا LSTM استفاده میشود. در خلق عکس و ویدیو هوش مصنوعی جدید، شبکههای GAN پیشتاز بازار هستند.

اگر میخواهید بیشتر درباره تفاوتهای شبکههای عصبی و سایر سیستمهای هوش مصنوعی بدانید، مقاله تفاوت هوش مصنوعی و یادگیری ماشین را بخوانید.

جمعبندی و راهنمای انتخاب

هر نوع شبکه عصبی مصنوعی، بسته به ساختار و کاربرد، بخشی از مسیر بلوغ هوش مصنوعی را تسهیل میکند. انتخاب صحیح وابسته به هدف پروژه، نوع داده (تصویری یا متنی) و میزان پیچیدگی مسئله است. مطالعه ساختارها و مقایسه مدلها، به طراحان و برنامهنویسان کمک زیادی در موفقیت پروژه میکند.

مشکلات رایج در آموزش شبکه عصبی و راهکارهای مقابله

یکی از چالشهای اساسی برای موفقیت پروژههای هوش مصنوعی و یادگیری ماشین، غلبه بر مشکلات فنی در آموزش شبکههای عصبی است. حتی پیشرفتهترین مدلها نیز اگر این موانع را درک و مدیریت نکنند، به خروجی دقیق و کاربردی نمیرسند. در ادامه رایجترین مشکلات آموزش شبکه عصبی و روشهای عملی و تخصصی رفع آنها را میبینید.

| مشکل | راهکارهای عملی |

|---|---|

| اورفیتینگ (Overfitting) |

|

| آندرفیتینگ (Underfitting) |

|

| گرادیان ناپدید شونده یا منفجر شونده |

|

| کمبود داده آموزشی |

|

| دادههای نامتعادل (Imbalanced Data) |

|

| نرخ یادگیری نامناسب (Learning Rate) |

|

| همگرایی کند یا ناپایدار (Slow/Unstable Convergence) |

|

| محدودیتهای محاسباتی (سختافزار/زمان) |

|

| شروع ضعیف وزنها (Poor Initialization) |

|

نکته تخصصی

برای پیشگیری از مشکلات آموزش شبکه عصبی، تست مداوم عملکرد مدل با دادههای اعتبارسنجی و تحلیل نمودارهای loss/accuracy بسیار کلیدی است. بسیاری از هوشهای مصنوعی موفق دقیقاً با رصد و رفع همین ایرادها به نتایج دقیق میرسند.

اگر علاقهمند به مفاهیم تنظیم مدل یا بهبود دقت شبکه هستید، پیشنهاد میکنیم مقاله یادگیری عمیق چیست؟ را بخوانید.

جمعبندی راهبردی

رفع مشکلات آموزش شبکه عصبی، رمز پیشرفت پروژههای هوش مصنوعی است. انتخاب درست راهکارها، تحلیل پیوسته نتایج و استفاده از ابزارهای مدرن به شما در مسیر ساخت مدلهای کارآمد و هوشمند کمک خواهد کرد.

چگونگی افزایش دقت شبکه عصبی با تنظیمات پیشرفته

یکی از اهداف اصلی توسعه شبکههای عصبی مصنوعی در حوزه هوش مصنوعی، دستیابی به حداکثر دقت و عملکرد بالاست. اما دقت یک شبکه عصبی صرفاً به معماری و داده محدود نمیشود؛ بلکه تنظیمات پیشرفته و بهینهسازی صحیح نقش کلیدی در افزایش موفقیت مدل دارند. در این بخش، مهمترین اهرمهای افزایش دقت را بهصورت کاربردی و تخصصی آموزش میدهیم.

کدام تنظیمات پیشرفته روی دقت شبکه عصبی تأثیرگذارند؟

- نرخ یادگیری (Learning Rate): یکی از حساسترین پارامترها که سرعت یادگیری وزنها را تعیین میکند. نرخ زیاد = پرشهای زیاد، نرخ کم = یادگیری کند.

- حجم دسته آموزش (Batch Size): تعداد نمونههایی که در هر بهروزرسانی وزنها استفاده میشوند. دسته کوچکتر = تنظیم دقیقتر وزنها،اما با نویز بیشتر.

- تعداد لایهها و نورونها: معماری عمیقتر (درباره یادگیری عمیق) ظرفیت شبکه را افزایش میدهد اما ریسک بیشبرازش را نیز بالا میبرد.

- انتخاب بهینهساز (Optimizer): مانند Adam، RMSprop یا SGD؛ هر کدام رفتار یادگیری متفاوتی دارد.

- تابع فعالسازی (Activation): مثل ReLU یا Sigmoid، که بر شناسایی الگوها اثر میگذارند.

تکنیکهای افزایش دقت مدل در هوش مصنوعی

- تنظیم هوشمند هایپراپارامترها: مانند نرخ یادگیری، وزنهای اولیه و تعداد دورههای آموزشی (epoch).

- استفاده از Cross Validation: ارزیابی مدل روی چندین زیرمجموعه داده برای اطمینان از پایداری دقت.

- Regularization (قانونمندسازی): استفاده از Dropout، L1 یا L2 برای جلوگیری از بیشبرازش (Overfitting).

- دادهافزایی (Data Augmentation): افزایش تنوع دادههای آموزشی (چرخش تصویر، نویز افزایی و...)

- استانداردسازی و نرمالسازی داده: باعث سریعتر و دقیقتر شدن یادگیری میشود.

- Early Stopping: توقف آموزش هنگام کاهش دقت تست؛ برای جلوگیری از یادگیری بیش از حد دادهی آموزشی.

- Model Checkpointing: ذخیره بهترین مدل در طول آموزش جهت جلوگیری از دست رفتن بهترین وضعیت.

- بهینهسازی تنظیمات پیشرفته با جستوجوی شبکهای (Grid Search)، تصادفی یا بایزی: تست ترکیبهای مختلف هایپراپارامترها برای یافتن بهترین جواب.

- بالانس کلاسها: ترکیب دادهها برای جلوگیری از غالب بودن یک کلاس خاص (کاربردی برای تشخیص بیماری، فیک و واقعی و...)

مقایسه مهمترین تنظیمات پیشرفته و تأثیرشان بر دقت

| تنظیم پیشرفته | توضیح کوتاه | تأثیر بر دقت |

|---|---|---|

| Learning Rate | سرعت تنظیم وزنها در آموزش | اگر درست تنظیم شود، افزایش دقت عالی; اگر نامناسب باشد، افت شدیدی ایجاد میکند. |

| Regularization | Dropout, L1/L2 برای کنترل بیشبرازش | کاهش ریسک overfitting و افزایش دقت در دادههای جدید |

| Batch Size | تعداد نمونه در هر بهروزرسانی وزنها | دسته کوچک: دقت بهتر، اما بیشتر نوسان دارد؛

دسته بزرگ: آموزش باثباتتر |

| Optimizer Type | نوع روش بهروزرسانی وزنها (Adam, SGD و ...) | انتخاب صحیح = یادگیری سریعتر و دقیقتر |

| Data Augmentation | ایجاد دادههای جدید از دادههای فعلی | افزایش چشمگیر دقت با تنوع دادن به دادهها |

| Early Stopping | توقف آموزش در بهترین نقطه | حفظ بهترین دقت حقیقی بر روی دادههای تست |

راهنمای اجرای تنظیمات پیشرفته به صورت گامبهگام

- قدم اول: دادهها را نرمالسازی کنید و یا augmentation را با ابزارهای مناسب اعمال نمایید.

- قدم دوم: به کمک Grid Search یا Random Search ترکیبهای نرخ یادگیری و حجم دسته را تست کنید.

- قدم سوم: Regularization مانند Dropout را با درصدهای مختلف اعمال و اعتبار مدل را ارزیابی کنید.

- قدم چهارم: با استفاده از Cross Validation نسبت به تعمیمپذیری مدل مطمئن شوید.

- قدم پنجم: در طول آموزش حتماً Early Stopping و Model Checkpointing را فعال نگه دارید.

- قدم ششم: دقت را با معیارهایی مثل accuracy, F1-score بسنجید تا بهترین مدل انتخاب شود.

نکته طلایی: اشتباهات رایج در تنظیمات پیشرفته شبکههای عصبی

- استفاده از نرخ یادگیری خیلی زیاد یا خیلی کم که میتواند منجر به نوسان یا توقف یادگیری شود.

- بیتوجهی به بیشبرازش و عدم استفاده از Regularization که باعث افت شدید دقت روی دادههای واقعی خواهد شد.

- آزمایش نکردن enough مقدار batch size و انتخاب Optimizer نامناسب متناسب با داده و شبکه.

- نادیده گرفتن Early Stopping و ذخیره بهترین مدل، مخصوصاً در پروژههای جدی و طولانی.

همیشه بعد از هر تغییر تنظیمات دقت و رفتار مدل را تست و تحلیل کنید.

منابع و یادگیری بیشتر

- مطالعه بیشتر درباره مفاهیم یادگیری ماشین و بهینهسازی تنظیمات

- آموزش شبکههای عصبی عمیق و ساختار آنها

- دسترسی به مثالها و کاربردهای هوش مصنوعی مدرن

آیا شما تجربهای از تنظیمات پیشرفته برای افزایش دقت شبکه عصبی در پروژههای هوش مصنوعی خود داشتهاید؟ تجربیات و نکات کاربردی خود را در کامنتهای همین مطلب با ما و دیگر علاقهمندان به اشتراک بگذارید!

در ادامه و در زیرعنوان بعدی، درباره نقش تحریمشکنها در توسعه شبکههای عصبی صحبت خواهیم کرد؛ چرا که بدون دسترسی آزاد به منابع و ابزارها، اعمال بسیاری از این تنظیمات و دریافت دادههای بهتر امکانپذیر نیست.

نقش تحریمشکنها در توسعه و آموزش شبکههای عصبی

رشد و توسعه هوش مصنوعی و شبکههای عصبی مصنوعی، نیاز شدیدی به دسترسی آزاد به منابع داده، ابزارهای نرمافزاری، سرویسهای ابری و پایگاههای علمی پیشرفته دارد. اما پژوهشگران و برنامهنویسان ایرانی به دلیل وجود تحریمها، اغلب برای دسترسی به امکانات حیاتی دچار چالشهای اساسی هستند. ابزارهای تحریمشکن نقش کلیدی در عبور از این موانع و تسهیل مسیر آموزش و توسعه مدلهای شبکه عصبی ایفا میکنند.

موانع مهم ناشی از تحریمها در مسیر توسعه هوش مصنوعی

- عدم دسترسی مستقیم به پلتفرمهای آموزشی مانند Google Colab و Kaggle

- محدود شدن استفاده از سرویسهای ابری قدرتمند (AWS, Azure, Google Cloud)

- مسدود بودن بسیاری از مخازن کد و دیتا در GitHub، HuggingFace و مشابه آن

- دسترسی دشوار به مقالات علمی، کنفرانسهای بینالمللی و ابزارهای پرداخت برای خرید سرویسها

- محدودیت استفاده از APIها و کتابخانههای هوش مصنوعی پیشرفته

تمامی این موانع باعث کند شدن پیشرفت علمی، افزایش هزینههای کسب مهارت و حتی خلل در یادگیری عملی میشود.

تحریمشکن چیست و چه کمکی به هوش مصنوعی و شبکه عصبی میکند؟

منظور از تحریمشکن در اینجا، هر ابزاری است که امکان دور زدن محدودیتهای دیجیتال، برداشتن قفلهای جغرافیایی و دسترسی به سرویسها، دادهها و سیستمهای هوشمند را فراهم میکند. این ابزارها با تغییر مسیر ترافیک اینترنت و پنهان کردن موقعیت واقعی کاربر، امکان استفاده از منابع حیاتی را به پژوهشگران ایرانی میدهند. به این ترتیب، فرد میتواند شبکه عصبی خود را روی سرویسهای ابری قدرتمند آموزش دهد، به مدلهای از پیشآموزشدیده جهان دسترسی داشته باشد یا حتی از جدیدترین دیتا و مقالهها بهره ببرد.

| ابزارها/سرویسها | بدون تحریمشکن | با تحریمشکن |

|---|---|---|

| Google Colab & Kaggle | اکثراً غیرقابل دسترس یا محدودشده | دسترسی کامل (رمز عبورهای رایگان GPU) |

| GitHub, HuggingFace, Papers | برخی ریپازیتوریها و فایلها مسدود است | امکان دانلود و مشارکت آزاد در پروژههای جهانی |

| سرویسهای ابری و API پیشرفته | محدودیت ثبتنام، خطای GeoIP | ثبتنام و درخواست آزمایشی ممکن میشود |

پرکاربردترین تحریمشکنها بین پژوهشگران ایرانی هوش مصنوعی

- Outline و V2Ray - سادگی تنظیم، سرعت بالا و پایداری اتصال؛ انتخاب محبوب بسیاری از دانشجویان و برنامهنویسان

- ShadowSocks - امنیت مناسب و امکان عبور از فیلترینگ چندلایه؛ به ویژه برای پروژههای بلندمدت کلاب و آموزش عمیق

- ایکس-کلش (X-CLASH) و اختاپوس - مناسب برای استفاده روی موبایل و دسکتاپ، همزمان Several connection و کاهش قطعیها

- ابزارهای اختصاصی آزمایشگاهی برخی دانشگاهها یا شرکتهای هوش مصنوعی

هشدار مهم: نکات حقوقی و امنیتی

استفاده از تحریمشکن برای دسترسی به سایتها و پلتفرمهای خارجی ممکن است محدودیتهای حقوقی و امنیتی به دنبال داشته باشد؛ مسئولیت استفاده با فرد است. همچنین خطر افشای دادههای حساس و ناپایداری گاهبهگاه اتصال وجود دارد. همیشه از ابزارهای معتبر و رمزنگاریشده و آنتیویروس استفاده کنید.

اثرگذاری تحریمشکنها بر شتاب نوآوری هوش مصنوعی در ایران

تجربه بسیاری از محققان ایرانی نشان میدهد که وقتی تحریمشکنها فعال هستند، دسترسی به پلتفرمهای یادگیری ماشین و دیتاستهای جهانی باعث میشود آموزش و راهاندازی شبکه عصبی با سرعت و کیفیتی نزدیک به استانداردهای جهانی انجام شود. این امر سطح پژوهش و مهارت نیروی انسانی را ارتقا، و تولید جدیدترین ایدهها را در بستر هوش مصنوعی امکانپذیر میکند.

اگر شما هم تجربه خاص یا راهکاری برای عبور موثر از محدودیتها و آموزش بهتر هوش مصنوعی با تحریمشکن داشتهاید، تجربیات خود را پایین همین مقاله کامنت کنید!