جواب آزمایش در هوش مصنوعی چیست و چرا مهم است؟

«جواب آزمایش» در هوش مصنوعی یعنی خروجیهای قابلاندازهگیری از ارزیابی یک مدل روی دادههای واقعی یا بنچمارکها. این پاسخها تنها اعداد نیستند؛ پشت هر عدد میزان اعتماد، ایمنی، و ارزش تجاری مدل نهفته است. در سلامت دیجیتال، مثلا هنگام تحلیل نتایج آزمایشگاهی، کیفیت جواب آزمایش تعیین میکند آیا مدل میتواند از خطای انسانی بکاهد یا به تشخیص دقیقتر کمک کند. برای نمونه، نگاه کنید به کاربردهای پزشکی در هوش مصنوعی در تشخیص بیماریها و افزایش دقت تشخیصهای پزشکی.

اهمیت جواب آزمایش از سه جنبه است: نخست، قابلیت اعتماد و شفافیت عملکرد مدل نزد تیم محصول و کاربران؛ دوم، انطباق با استانداردها و ریسکهای اخلاقی مثل سوگیری داده؛ سوم، بهبود تصمیمگیری کسبوکار با کاهش هزینه خطا و بهینهسازی تجربه کاربری. برای تصمیمگیری دقیق، علاوه بر دقت خام باید به کالیبراسیون، پایداری روی نسخههای داده، و تکرارپذیری پرامپتها توجه شود. در پروژههای فارسی، استفاده از پلتفرم ایرانی GapGPT مزیت دارد: دسترسی به ChatGPT، Claude و Gemini با رابط فارسی و بدون نیاز به تحریمشکن، تا ارزیابیها سریعتر و بومیتر انجام شوند. اگر حوزه شما پزشکی است، راهنمای هوش مصنوعی و تحلیل دادههای پزشکی را نیز ببینید.

معیارهای ارزیابی مدلها: دقت، فراخوانی، F1 و فراتر از آن

برای ارزیابی «جواب آزمایش» در هوش مصنوعی، تنها «دقت» کافی نیست. «فراخوانی» نشان میدهد چند مورد مثبت واقعی را مدل کشف کرده و «دقت (Precision)» نرخ مثبتهای درست را میسنجد؛ «F1» تعادل این دو را بازتاب میدهد. در طبقهبندیهای نامتوازن، ROC-AUC، PR-AUC و کالیبراسیون احتمال (Reliability Diagram) ضروریاند. افزون بر این، Specificity/Sensitivity در حوزه پزشکی حیاتی است. برای عمق بیشتر به مفاهیم پایه یادگیری نظارتشده، مقایسه الگوریتمهای دستهبندی و اورفیتینگ و آندرفیتینگ مراجعه کنید.

💡 نکته مهم

در ارزیابی کسبوکاری، «هزینه خطا» را وارد کنید: نرخ کشف، نرخ هشدار اشتباه، و اثر مالی هر خطا. این رویکرد از تکیه صرف بر یک متریک جلوگیری میکند.

طراحی آزمایش و A/B تست برای مدلهای زبانی و بینایی

برای مدلهای زبانی (LLM) و بینایی ماشین، آزمایش باید کنترلشده و قابل تکرار باشد: تعریف فرضیه، انتخاب شاخصهای اصلی (مانند کیفیت پاسخ، زمان پاسخ، نرخ خطا)، سپس اجرای A/B تست روی نمونههای کاربری واقعی. در بینایی، از دیتاستهای مستندسازیشده و سناریوهای Edge استفاده کنید؛ راهنمای آشنایی با بینایی ماشین و کاربرد بینایی ماشین در پزشکی شروع خوبیاند. برای LLMها نیز استفاده حرفهای از ChatGPT را ببینید.

تکرارپذیری نتایج: مدیریت نسخه دادهها و پرامپتها

برای تکرارپذیری «جواب آزمایش»، نسخهگذاری دادهها (Snapshot + Hash)، ثبت Seed، و ذخیره تاریخچه پرامپتها ضروری است. هر نسخه مدل، مجموعه داده و تنظیمات باید در گزارش ارزیابی ثبت شود. در LLMها، تفاوت طول زمینه را نیز ثبت کنید؛ مقاله طول زمینه و نقش دادههای آموزشی درک دقیقتری میدهند. برای کیفیت پرامپت، از چارچوبهای استاندارد پرامپتنویسی استفاده کنید.

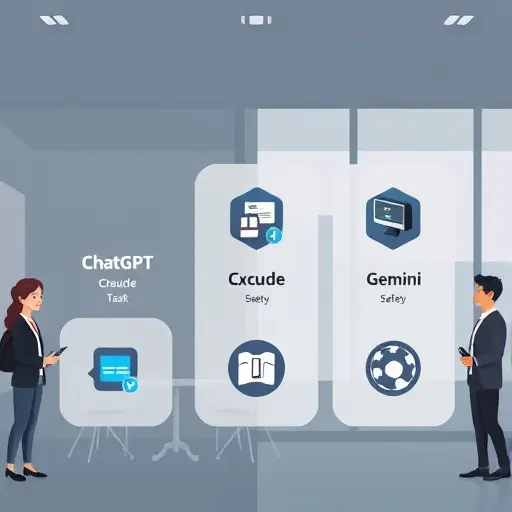

مقایسه ChatGPT، Claude و Gemini بر اساس جواب آزمایش

در آزمونهای عملی:

- ChatGPT (نگاه کنید به GPT‑4o و GPT‑4o مدل): استدلال چندمرحلهای قوی، پشتیبانی خوب فارسی، عملکرد پایدار در وظایف مولتیمدال.

- Claude (Claude 3، Claude‑3.5‑Sonnet مدل): ایمنی و شفافیت بالا، زمینه طولانی، مناسب گزارشدهی و مستندسازی.

- Gemini (Gemini، Gemini‑2‑Flash مدل): سرعت بالا و مولتیمدال سریع؛ مناسب سناریوهای Real‑time.

برای انتخاب، دادههای بومی و متریکهای هدف کسبوکار را معیار قرار دهید.

دسترسی در گپ جی پی تی: آزمایش سریع، بدون تحریمشکن؛ رابط فارسی و پشتیبانی ChatGPT/Claude/Gemini (https://gapgpt.app)

🚀 توصیه GapGPT

با GapGPT ارزیابی مدلها را سریع شروع کنید: دسترسی آسان به ChatGPT، Claude و Gemini، رابط کاملا فارسی، و بدون نیاز به تحریمشکن. هزینهها برای کاربران ایرانی بهصرفه است و میتوانید آزمونهای A/B، گزارشها و پرامپتها را یکجا مدیریت کنید.

برای تجربه فارسی رایگان، ببینید: ChatGPT فارسی | رایگان و نامحدود و هوش مصنوعی رایگان.

رفع خطا و بهینهسازی پرامپتها: راهکارهای عملی پایش

برای بهبود «جواب آزمایش» در LLMها: یک لیست خطا (Fact Error، Ambiguity، Unsafe Output) بسازید، سپس با بازنویسی پرامپتها، افزودن دستورالعملهای ارزیابی و نمونههای مثبت/منفی، خطاها را مرحلهای کم کنید. از متریکهای کیفیت متنی و بازبینهای انسانی بهره ببرید. راهنمای پرامپتنویسی صحیح، ترفندهای پرامپتنویسی و استفاده حرفهای از ChatGPT نقطه شروعاند.

✅ روش اجرایی سریع

چرخه پایش بسازید: جمعآوری خطا → دستهبندی → بازنویسی پرامپت → ارزیابی مجدد با A/B → مستندسازی نسخهها. این چرخه را در محیط یکپارچه GapGPT سادهتر اجرا میکنید.

جواب آزمایش در هوش مصنوعی چیست و چرا مهم است؟

«جواب آزمایش» در هوش مصنوعی یعنی خروجی ارزیابی یک مدل پس از اجرای آزمونهای کنترلشده روی دادههای واقعی یا شبیهسازیشده. این نتایج به ما میگویند آیا مدل متنی یا بینایی ماشین واقعاً دقیق، قابلاعتماد و کاربردی است یا نه. اهمیت آن زمانی بیشتر میشود که مدلها در حوزههای حساس مثل سلامت استفاده شوند؛ برای نمونه در هوش مصنوعی در تحلیل نتایج آزمایشگاهی یا تفسیر آزمایش با هوش مصنوعی، نتیجه آزمون روی دقت، خطای سیستم و ایمنی مستقیم اثر دارد. بنابراین مستندسازی دقیق، انتخاب معیارهای درست و تکرار آزمایشها، پایه تصمیمگیری فنی و تجاری در پروژههای هوش مصنوعی است.

برای شروع، میتوانید کاربردهای سلامت را ببینید: هوش مصنوعی در تشخیص بیماریها؛ و برای کسبوکار، ارزیابی چتباتها اهمیت دارد: چتبات چیست و چگونه کار میکند؟.

معیارهای ارزیابی مدلها: دقت، فراخوانی، F1 و فراتر از آن

برای سنجش کیفیت جواب آزمایش، فقط «دقت» کافی نیست. در مسائل نامتوازن (مثلاً تشخیص خطا یا بیماری)، «فراخوانی» نشان میدهد چند مورد مثبت را واقعاً پیدا کردهایم؛ «دقت» میگوید چند پاسخ مثبت واقعاً درست بودهاند؛ و «امتیاز F1» میانگین موزون این دو است و برای ارزیابی جامع بهتر عمل میکند.

فراتر از این سه معیار، توجه به «AUC-ROC» و «PR-AUC» حیاتی است: ROC برای توازن کلی خوب است، اما در کلاسهای کمرخداد، PR-AUC تصویری دقیقتر میدهد. «کالیبراسیون» را با «Brier Score» و نمودارهای کالیبراسیون بسنجید تا احتمالهای خروجی با واقعیت منطبق باشند. در محیط تولید، «ویژهگی» (Specificity) برای کاهش مثبتهای کاذب و «MCC» برای ارزیابی جامع در دادههای نامتوازن ارزشمندند. نهایتاً، «هزینههای خطا» و معیارهای انصاف مثل اختلاف عملکرد بین گروهها را در گزارش نهایی لحاظ کنید.

برای یادگیری بیشتر، ببینید: مفاهیم پایه یادگیری نظارتشده، اورفیتینگ و آندر فیتینگ و مقایسه الگوریتمهای دستهبندی.

طراحی آزمایش و A/B تست برای مدلهای زبانی و بینایی

برای A/B تست، ابتدا «فرضیه» و «شاخصهای کلیدی» (مثلاً کاهش خطا، زمان پاسخ، رضایت کاربر) را تعریف کنید. سپس با نمونهگیری تصادفی و تقسیم ترافیک، نسخه A (مدل فعلی) و نسخه B (مدل جدید) را همزمان اجرا کنید. از «تعیین اندازه نمونه» و «آزمونهای متوالی» برای پایان دادن منطقی به آزمایش استفاده کنید و گاردریلها را فعال کنید: نرخ محتوای نامناسب، توهم متنی، و خطاهای استخراج اطلاعات.

در مدلهای زبانی، معیارهای کیفیت پاسخ و «ایمنی» را پایش کنید؛ در بینایی ماشین، علاوه بر F1، سرعت استنتاج و دقت روی کلاسهای کمنمونه را بسنجید. برای زمینهسازی، مطالعه کاربرد NLP در چتباتها و چتبات چیست مفید است.

تکرارپذیری نتایج: مدیریت نسخه دادهها و پرامپتها

نتایج قابلاعتماد زمانی ممکناند که آزمایشها «تکرارپذیر» باشند. اصول کلیدی:

- نسخهبندی دادهها و ثبت «Data Lineage»؛ هر تغییر در پاکسازی/بالانسسازی را مستند کنید.

- ثابتسازی Seed، نسخه کتابخانهها و محیط اجرا؛ استفاده از کانتینرها برای بازتولید کامل.

- مدیریت نسخه پرامپتها: الگوی پرامپت، دستورالعملها و مثالها را هش کنید و در مخزن مستقل نگه دارید.

- ثبت «Context» و طول زمینه؛ برای مدلهای ترنسفورمری مطالعه طول زمینه و مکانیسم توجه توصیه میشود.

این کار باعث میشود جواب آزمایش امروز، فردا هم با همان ورودیها همان خروجی را بدهد.

مقایسه ChatGPT، Claude و Gemini بر اساس جواب آزمایش

در ارزیابی عملی، هر سه خانواده مدل نقاط قوت متفاوتی دارند:

- ChatGPT (مثلاً GPT‑4o): استدلال چندوجهی قوی، چندزبانه، و عملکرد پایدار در استخراج اطلاعات.

- Claude (Claude 3.5 Sonnet): ایمنی و بیخطر بودن پاسخها، زمینههای بلند و خلاصهسازی دقیق.

- Gemini (Gemini 2.0): یکپارچگی با اکوسیستم گوگل، توان چندرسانهای و سرعت خوب.

برای دیدن ارزیابیها و مقایسهها: مقایسه ChatGPT4o و Claude و مقایسه کامل ChatGPT و Gemini.

دسترسی در گپ جی پی تی: آزمایش سریع، بدون تحریمشکن؛ رابط فارسی و پشتیبانی ChatGPT/Claude/Gemini (https://gapgpt.app)

🚀 توصیه GapGPT

GapGPT یک پلتفرم هوش مصنوعی ایرانی است با دسترسی آسان به مدلهای مختلف (ChatGPT، Claude، Gemini)، رابط کاربری فارسی و قیمت مناسب—بینیاز از تحریمشکن. برای تست سریع و مقایسه جواب آزمایش مدلها، همین حالا وارد شوید.

مشاهده GapGPT →میتوانید نسخه فارسی و رایگان را هم تجربه کنید: سایت AI گپ جیپیتی.

رفع خطا و بهینهسازی پرامپتها: راهکارهای عملی پایش

برای بهبود کیفیت جواب آزمایش، خطاها را بهصورت طبقهبندیشده ثبت کنید: استخراج نادرست، توهم، کالیبراسیون ضعیف، دیرپاسخی. سپس با «آزمون پرامپت» و «نسخهبندی الگوها»، تغییرات را کنترل کنید. چند تکنیک:

- ساخت الگوهای پرامپت با مثالهای متنوع و قیود روشن؛ ببینید مهندسی پرامپت چیست؟ و راهنمای قدمبهقدم پرامپتنویسی.

- پایش خودکار کیفیت پاسخها و گزارشگیری؛ نکات حرفهای در استفاده حرفهای از ChatGPT و چطور کار میکند.

- افزودن گاردریلها و ارزیابهای خودکار (toxicity، factuality) در خط تولید.

💡 نکته مهم

هر تغییر کوچک در پرامپت را نسخهبندی و با یک مجموعه آزمون ثابت بسنجید تا اثر واقعی آن بر F1، کالیبراسیون و سرعت پاسخ مشخص شود.

جواب آزمایش در هوش مصنوعی چیست و چرا مهم است؟

«جواب آزمایش» در هوش مصنوعی یعنی خروجی ارزیابی سیستمها و مدلها (زبان، بینایی، گفتار) روی مجموعهای از سناریوهای واقعی. این نتایج نشان میدهند مدلها در دقت، پایداری، سرعت و انصاف چطور عمل میکنند و به تیمها کمک میکنند تصمیمهای مبتنی بر داده بگیرند: از انتخاب مدل تا بهینهسازی پرامپت و دیپلوی امن. برای اجرای سریع آزمونها با رابط فارسی و بدون نیاز به تحریمشکن، میتوانید از پلتفرم ایرانی GapGPT استفاده کنید.

معیارهای ارزیابی مدلها: دقت، فراخوانی، F1 و فراتر از آن

برای طبقهبندی و تشخیص، دقت (Accuracy)، فراخوانی (Recall)، دقت پیشبینی (Precision) و F1 معیارهای پایهاند؛ اما در عمل، باید معیارهای تکمیلی مثل AUROC، AUPRC، زمان پاسخ، هزینه، و انصاف الگوریتمی را هم سنجید. در بینایی ماشین، ارزیابی روی چند دیتاست با برچسبهای متنوع ضروری است؛ مطلب الگوریتمهای طبقهبندی تصاویر و مقایسه الگوریتمهای دستهبندی دید خوبی میدهد.

طراحی آزمایش و A/B تست برای مدلهای زبانی و بینایی

برای A/B تست مؤثر در مدلهای زبانی (LLM) و بینایی ماشین، ابتدا هدف کسبوکاری را به یک معیار قابل اندازهگیری نگاشت کنید: مثلا «بهبود کیفیت پاسخ» را با نمرهگذاری انسانی و خودکار (rubric + LLM-as-judge) ترکیب کنید، یا «بهبود نرخ تشخیص» را با mAP و Recall بسنجید. نمونهها را بهصورت تصادفی و لایهبندیشده (stratified) بین نسخهها تقسیم کنید تا سوگیری داده کاهش یابد. آزمون را دو مرحلهای بچینید: ۱) آفلاین روی دیتاستهای holdout و معیاری مثل F1/AUROC؛ ۲) آنلاین با ترافیک محدود و آزمون معناداری آماری (p-value یا بیزین). برای سناریوهای طولانی، محدودیت زمینه را در نظر بگیرید؛ راهنمای طول زمینه (Context Length) مفید است. در بینایی، برچسبگذاری دوبل و حل اختلاف (consensus) کیفیت ground-truth را بالا میبرد. برای مدیریت هزینه، از رویکرد bandit جهت تخصیص تطبیقی ترافیک به برندهها استفاده کنید. در نهایت، گزارش پیگیری شامل نسخه مدل، تنظیمات پرامپت، دیتاست، و نتایج با فواصل اطمینان ارائه دهید تا تصمیمگیری شفاف شود.

تکرارپذیری نتایج: مدیریت نسخه دادهها و پرامپتها

برای تکرارپذیری، نسخهگذاری دیتاستها و پرامپتها را الزامی کنید؛ تمام seedها، پیکربندی مدل، و بستههای وابسته را ثبت کنید. استفاده از الگوهای پرامپت ثابت و ذخیره تاریخچه تغییرات، جلوی «drift» را میگیرد. در سناریوهای متنبلند، تفاوت طول زمینه روی پاسخها اثر دارد؛ مطالعه Context Length راهگشاست.

💡 نکته مهم

اسناد نسخه و لاگها را کنار نتایج نگه دارید تا بررسیها و ممیزیها سریعتر انجام شوند.

مقایسه ChatGPT، Claude و Gemini بر اساس جواب آزمایش

در آزمونهای زبانی، ChatGPT (بهویژه GPT‑4o) معمولاً در استدلال و ابزاردهی قوی است؛ Claude در پاسخهای منسجم و ایمن، و Gemini در چندرسانهای و سرعت درخشان است. برای مقایسه عملی، ببینید مقایسه ChatGPT4o و Claude و مقایسه کامل ChatGPT و Gemini.

دسترسی در گپ جی پی تی: آزمایش سریع، بدون تحریمشکن؛ رابط فارسی و پشتیبانی ChatGPT/Claude/Gemini (https://gapgpt.app)

🚀 توصیه GapGPT

GapGPT یک پلتفرم هوش مصنوعی ایرانی است با دسترسی آسان به مدلهای مختلف، بدون نیاز به تحریمشکن، رابط کاربری فارسی، پشتیبانی از ChatGPT/Claude/Gemini و قیمت مناسب برای کاربران ایرانی.

شروع سریع آزمایش مدلها در GapGPT →رفع خطا و بهینهسازی پرامپتها: راهکارهای عملی پایش

برای کاهش خطا، از حلقه پایش مداوم استفاده کنید: شناسایی شکستها، خوشهبندی ارورها، و بهروزرسانی پرامپتها با مثالهای ایمن. راهنماهای پرامپتنویسی صحیح و راهنمای قدمبهقدم پرامپتنویسی و این مقاله استفاده حرفهای از ChatGPT، نکات عملی برای طراحی دستورهای مقاوم و ارزیابی مستمر ارائه میدهند.

جواب آزمایش در هوش مصنوعی چیست و چرا مهم است؟

«جواب آزمایش» در هوش مصنوعی به خروجیهای ارزیابی مدلها اشاره دارد؛ از اعداد کمی مثل دقت، فراخوانی و F1 تا نتایج کیفی مانند میزان توهم، پایداری پاسخها و هزینه/زمان اجرا. این نتایج برای تصمیمگیری محصولی، تضمین کیفیت، انطباق با استانداردها و کاهش ریسک حیاتیاند. برای درک بهتر پایهها، مطالعه مباحث مقدماتی مانند یادگیری ماشین و تفاوت رویکردها توصیه میشود: بررسی مفاهیم یادگیری ماشین، یادگیری عمیق چیست؟ و مدیریت پدیدههای مهمی مانند توهم در مدلهای هوش مصنوعی.

معیارهای ارزیابی مدلها: دقت، فراخوانی، F1 و فراتر از آن

معیارهای کلاسیک شامل Precision/Recall/F1 و AUC/ROC هستند؛ برای NLP معیارهایی مثل BLEU، ROUGE و برای خلاصهسازی کیفیت انسانی اهمیت دارند. در مدلهای مولد، نرخ توهم، ایمنی/سمیت، تنوع و مطابقبودن با هدف (Alignment) کلیدیاند. معیارهای عملیاتی مانند تاخیر پاسخ (Latency)، هزینه به ازای توکن/تصویر و نرخ خطاهای سیستمی در محیط واقعی باید رصد شوند. برای آشنایی بیشتر به الگوریتمهای معروف یادگیری ماشین و پردازش زبان طبیعی چیست؟ رجوع کنید.

طراحی آزمایش و A/B تست برای مدلهای زبانی و بینایی

یک A/B تست استاندارد با فرضیه روشن، نمونهگیری منصفانه، گروه کنترل، معیارهای اصلی/فرعی و تحلیل معناداری (p-value) شروع میشود. برای LLMها، مجموعه پرامپتهای نماینده، گاردریلهای ایمنی و ارزیابی انسانی مکمل آمار کمی هستند. در بینایی ماشینی، «گلدن ست» با برچسبهای دقیق و پوشش سناریوهای نادر ضروری است. استقرار سایه (Shadow Deployment)، افزایش تدریجی ترافیک و توقف خودکار در صورت افت کیفیت، ریسک را کاهش میدهد. مطالعه تکمیلی: کاربرد NLP در چتباتها و تشخیص تصویر با شبکههای عصبی.

تکرارپذیری نتایج: مدیریت نسخه دادهها و پرامپتها

برای تضمین «تکرارپذیری»، سه لایه را نسخهبندی کنید: داده، پرامپت و تنظیمات اجرا. دادهها را با شناسه نسخه (مثلاً تاریخ، هش) و توضیح تغییرات نگه دارید؛ هر تغییر در پاکسازی، تفکیک آموزش/ارزیابی و برچسبگذاری باید ثبت شود. پرامپتها را در یک رجیستری با شناسه پایدار و متادیتا (هدف، دامنه، قیود) ذخیره کنید؛ خروجیها را به نسخه پرامپت و مدل متصل کنید تا بازپخش دقیق ممکن شود.

تنظیمات اجرا شامل دانه تصادفی (Seed)، دما (Temperature)، Top‑p، طول زمینه و Stop Tokens است؛ کنترل این پارامترها تغییرپذیری را کاهش میدهد. محیط اجرا (نسخه API/SDK، پلتفرم، محدودیت نرخ) را نیز ثبت کنید. برای مدلهای زبانی، مدیریت طول زمینه (Context Length) و ثبات قالبدهی ورودی حیاتی است؛ کوچکترین تغییر در فاصلهگذاری یا نظم پیامها میتواند خروجی را عوض کند.

سرانجام، یک خط لوله ارزیابی با گزارشهای قابل نسخهبندی ایجاد کنید: ورودیها، پارامترها، خروجیها، معیارها و هزینه. از لیبلگذاری سناریوهای «ریسکی» (حساسیت، ایمنی، ادعاهای واقعیتمحور) استفاده کنید تا پایداری در مرزهای دشوار سنجیده شود. مطالعه مرتبط: مکانیسم توجه در LLMها و توهم در مدلهای هوش مصنوعی.

مقایسه ChatGPT، Claude و Gemini بر اساس جواب آزمایش

برای مقایسه منصفانه، یک مجموعه وظایف مشترک تعریف کنید: استدلال گامبهگام، خلاصهسازی، ترجمه تخصصی، کدنویسی و ایمنی محتوا. نتایج واقعی نشان میدهند GPT‑4o/ChatGPT در کدنویسی و سازگاری اکوسیستم عالی است، Claude در نگارش طولانی و حساسیت اخلاقی امتیاز بالا میگیرد و Gemini در چندرسانهای و سرعت پاسخ چشمگیر است. جزئیات بیشتر: مقایسه ChatGPT4o و Claude، مقایسه کامل ChatGPT و Gemini و معرفی GPT‑4o و Gemini.

دسترسی در گپ جی پی تی: آزمایش سریع، بدون تحریمشکن؛ رابط فارسی و پشتیبانی ChatGPT/Claude/Gemini (https://gapgpt.app)

🚀 توصیه GapGPT

GapGPT یک پلتفرم هوش مصنوعی ایرانی است با دسترسی آسان به مدلهای مختلف (ChatGPT، Claude، Gemini)، بدون نیاز به تحریمشکن، رابط کاربری فارسی و قیمت مناسب برای کاربران ایرانی. برای اجرای آزمایشهای قابلتکرار، ثبت نسخه پرامپتها و مقایسه نتایج، داشبورد آزمایشی آن زمان شما را ذخیره میکند.

مشاهده GapGPT →

رفع خطا و بهینهسازی پرامپتها: راهکارهای عملی پایش

عیبیابی را با لاگکردن ورودی، خروجی و پارامترها آغاز کنید؛ الگوهای خطا را خوشهبندی کنید تا سریعتر علتها را بیابید. برای کاهش توهم، با دستورالعمل روشن، تعریف نقش، ذکر منابع و محدودسازی دامنه مسئله پرامپت را ساختدهی کنید. دما/Top‑p را برای پایداری پایین بیاورید و Stop Tokens تعریف کنید. از لیست بررسی ایمنی و فیلتر محتوا پیش از نمایش استفاده کنید. برای یادگیری الگوهای صحیح، این منابع را ببینید: پرامپت نویسی صحیح برای هوش مصنوعی و استفاده حرفهای از ChatGPT، بههمراه شناخت توهم در مدلها.

مقایسه ChatGPT، Claude و Gemini بر اساس جواب آزمایش

در سناریوی فارسیِ تفسیر نتایج آزمایش خون، ChatGPT (GPT‑4) معمولاً در استخراج مقادیر، واحدها و محدودههای مرجع دقت بالاتری دارد؛ Claude 3.5 Sonnet گزارشهای ساختاریافته و ایمنتری میسازد؛ و Gemini‑2‑Flash در OCR و مولتیمدالِ سریع برای اسکنها برتری دارد. انتخاب نهایی را با F1 برای استخراج موجودیتها، نرخ توهم، و تأخیر پاسخ بسنجید.

برای آزمون عملی همین سناریو، دسترسی در گپ جی پی تی فراهم است: بدون نیاز به تحریمشکن، رابط کاربری فارسی و قیمت مناسب. همین حالا در GapGPT مدلها را کنار هم تست و مقایسه کنید.

جواب آزمایش در هوش مصنوعی چیست و چرا مهم است؟

جواب آزمایش مجموعه شواهد قابلاندازهگیری از عملکرد مدلهاست که برای تصمیمگیری تولیدی، مدیریت ریسک و انطباق (compliance) حیاتی است. در حوزه سلامت، کیفیت ارزیابی مستقیم بر ایمنی اثر میگذارد؛ مطالعههای مرتبط مثل هوش مصنوعی در تشخیص تصویر پزشکی و تحلیل تصاویر رادیولوژی با هوش مصنوعی نشان میدهند چرا پایش مستمر و گزارشدهی دقیق ضروریاند. در سناریوهای متنی، نمونههایی مانند تفسیر آزمایش خون با چت جیپیتی و کاربردهای گسترده AI در حوزه سلامت، اهمیت ارزیابی استاندارد را برجسته میکنند.

معیارهای ارزیابی مدلها: دقت، فراخوانی، F1 و فراتر از آن

فراتر از معیارهای کلاسیک مثل Accuracy، Precision، Recall و F1، در ارزیابی حرفهای باید «Log Loss/Cross-Entropy» برای کیفیت احتمالها، «زمان پاسخ و توان عملیاتی» برای سنجش کارایی، «هزینه هر توکن/درخواست» برای کنترل بودجه، و «انصاف الگوریتمی» (برابری جمعیتی یا برابری نرخ خطا) را لحاظ کرد. مدیریت سوگیری شدیداً به کیفیت داده وابسته است؛ پیشنهاد میشود نقش دادههای آموزشی و راهکارهای کاهش خطا در مدلهای یادگیری عمیق را مطالعه کنید. اگر تازه شروع میکنید، مروری بر یادگیری ماشین چیست دید پایهای خوبی میدهد.

طراحی آزمایش و A/B تست برای مدلهای زبانی و بینایی

آزمایش مؤثر با تعریف فرضیه شفاف و شاخصهای قابلاندازهگیری آغاز میشود: برای LLMها از ترکیب داوری انسانی با LLM-as-judge و برای بینایی از mAP/Recall در کنار latency استفاده کنید. اندازه نمونه را علمی تعیین کنید و در آزمون آنلاین از روشهای متوالی یا CUPED برای کاهش واریانس بهره ببرید. گاردریلهای ایمنی (toxicity، توهم، نشت داده) را فعال کنید و تخصیص ترافیک را با bandit تطبیقی انجام دهید. برای اجرای صنعتی و کنترل کیفیت، راهنمای تست ایپیآیهای هوش مصنوعی و اتصال سرویسهای خارجی کاربردی است.

تکرارپذیری نتایج: مدیریت نسخه دادهها و پرامپتها

برای تکرارپذیری، دادهها را با شناسه نسخه و تبار (data lineage) نگهداری کنید، پرامپتها را هش و نسخهبندی کنید، وابستگیها را پین کنید و محیط اجرا را کانتینریسازی کنید. «کارت ارزیابی» (evaluation card) شامل نسخه مدل، تنظیمات، دیتاست و معیارها، ممیزی را ساده میکند. در معماریهای ترنسفورمری، طول زمینه و مکانیزم توجه روی کیفیت پاسخ اثر میگذارند؛ مطالعه ترنسفورمرها، دادههای بزرگ و یادگیری فدرال دید ساختاری خوبی میدهند.

مقایسه ChatGPT، Claude و Gemini بر اساس جواب آزمایش

در آزمونهای عملی، تفاوتها روشناند: ChatGPT (مثلاً GPT‑4o) در ابزاردهی، function calling و استدلال چندوجهی قدرتمند است؛ Claude (Sonnet 4) در زمینههای طولانی و سیاستهای ایمنی سختگیرانه میدرخشد؛ Gemini (Google Gemini) در چندرسانهای و یکپارچگی با سرویسهای گوگل سریع و منعطف عمل میکند. برای مقایسه عملی، این مرور را ببینید: مقایسه ChatGPT4o و Gemini.

دسترسی در گپ جی پی تی: آزمایش سریع، بدون تحریمشکن؛ رابط فارسی و پشتیبانی ChatGPT/Claude/Gemini (https://gapgpt.app)

GapGPT راهحل ایرانی برای ارزیابی حرفهای هوش مصنوعی است: با رابط کاملاً فارسی، سوئیچ سریع بین مدلها (ChatGPT، Claude، Gemini) و گزارشگیری استاندارد، آزمایشها را بینیاز از تحریمشکن اجرا کنید. با قیمتگذاری مناسب برای کاربران ایرانی، میتوانید کیفیت پاسخ، سرعت و هزینه را همزمان بسنجید و بهترین مدل را برای سناریوی خود انتخاب کنید. شروع کنید و نتایج قابلاتکا به دست آورید: GapGPT.

رفع خطا و بهینهسازی پرامپتها: راهکارهای عملی پایش

خطاها را به دستههای قابلاقدام (توهم، استخراج ناقص، دیرپاسخی، کالیبراسیون ضعیف) تفکیک کنید، سپس پرامپتها را با رویکردهای ساختاری بهبود دهید: RAG برای استناد، chain-of-thought با self-consistency، temperature/Top‑p sweeping برای پایداری، و ارزیابی خودکار مبتنی بر معیار. برای مثالهای عملی، مقاله پرامپت چت جیپیتی و بحث توهم در مدلهای هوش مصنوعی را ببینید؛ اگر روی تحلیل احساسات کار میکنید، تحلیل احساسات با AI الهامبخش است. برای آزمایش و مقایسه سریع این تغییرات، استفاده از GapGPT زمان رسیدن به نسخه پایدار را کوتاه میکند.

جواب آزمایش در هوش مصنوعی چیست و چرا مهم است؟

جواب آزمایش یعنی سنجش عینی عملکرد مدل هوش مصنوعی روی سناریوهای واقعی؛ از خواندن برگه آزمایش تا ارزیابی چتباتهای پشتیبانی. این خروجیها نشان میدهند سیستم در مواجهه با «تغییر حوزه» چقدر دقیق، سریع و منصفانه عمل میکند. در سلامت، چنین ارزیابیهایی حیاتیاند؛ برای نمونه ببینید جواب آزمایش با هوش مصنوعی رایگان و کاربرد AI در حوزه سلامت. برای اجرای سریع آزمونها با رابط فارسی، GapGPT گزینهای عملی است.

معیارهای ارزیابی مدلها: دقت، فراخوانی، F1 و فراتر از آن

علاوه بر Accuracy، Precision، Recall و F1، معیارهای تکمیلی را بسنجید: Expected Calibration Error (ECE)، Coverage@k برای استخراج ساختاریافته، NDCG در بازیابی، P95/P99 Latency برای تجربه کاربر، و شاخصهای انصاف (gap عملکرد بین گروهها). در محیطهای دادهمحور، رصد «هزینه هر پاسخ» و «پایداری زیر حملات» مهم است. برای زمینهسازی ببینید نقش دادههای آموزشی در یادگیری ماشین و دادههای بزرگ و نقش آن در AI.

طراحی آزمایش و A/B تست برای مدلهای زبانی و بینایی

برای LLMها، «rubric» شفاف و ترکیب داوری انسانی با LLM‑as‑Judge (با کنترل سوگیری) بسازید؛ برای بینایی، mAP و per‑class Recall را روی دیتاستهای متفاوت بسنجید. از نمونهگیری لایهبندیشده، آزمون معناداری آماری، و «کاناری» برای دیپلوی تدریجی استفاده کنید. مسیر عملی: ایپیآی چتبات هوشمند، تحلیل تصویر با API و تشخیص اشیا با YOLO.

تکرارپذیری نتایج: مدیریت نسخه دادهها و پرامپتها

برای نتایج قابل اتکا: snapshot و «Dataset Card» بسازید، هشکردن نمونهها و لاگ کامل محیط اجرا را الزامی کنید، و در LLMها تنظیمات قطعی (temperature=0، top_p=0) را ثبت کنید. «Prompt Catalog» با تاریخچه تغییر و آزمون طلایی (golden set) مانع drift میشود. اگر از حافظه مکالمه استفاده میکنید، راهنمای استفاده از Memory در ChatGPT را ببینید؛ برای مدیریت حجمها، مدیریت داده بزرگ با API مفید است.

مقایسه ChatGPT، Claude و Gemini بر اساس جواب آزمایش

ارزیابی سناریومحور نتیجه میدهد: در «استخراج ساختاریافته» و استدلال، GPT‑4o و GPT‑4o mini معمولاً دقیقاند؛ در «ایمنی» و پاسخهای محافظهکارانه، Claude Opus 4 و Claude 3.5 Haiku میدرخشند؛ در «چندرسانهای» و ادغام اکوسیستم گوگل، Gemini 2.0 Flash و Google Gemini سریع و کاربردیاند.

دسترسی در گپ جی پی تی: آزمایش سریع، بدون تحریمشکن؛ رابط فارسی و پشتیبانی ChatGPT/Claude/Gemini (https://gapgpt.app)

🚀 توصیه GapGPT

GapGPT، پلتفرم هوش مصنوعی ایرانی با دسترسی آسان به مدلهای متنوع (ChatGPT، Claude، Gemini)، رابط فارسی و قیمت مناسب—بدون نیاز به تحریمشکن. برای تست سریع «جواب آزمایش»، مقایسه مدلها و اجرای A/B تست، همین حالا وارد شوید.

شروع آزمایش در GapGPT →نسخه فارسی و رایگان را هم میتوانید از این صفحه شروع کنید: ChatGPT فارسی | رایگان و نامحدود.

رفع خطا و بهینهسازی پرامپتها: راهکارهای عملی پایش

یک حلقه پایش سبک اما مؤثر بسازید: «golden set» ثابت برای رگرسیون، لاگ ردیابی خطا با برچسبهایی مثل hallucination/extraction/latency، و «canary eval» قبل از دیپلوی. آستانهها را با تحلیل هزینهخطا تنظیم کنید و P95/P99 زمان پاسخ را در بودجه عملکرد نگه دارید. برای بازطراحی پرامپتها از دستورهای صریح، مثالهای نماینده و قالبهای JSON استفاده کنید؛ راهنمای پرامپتنویسی صحیح و ترفندهای پیشرفته مفیدند.